生成式人工智能中的变换器是什么?

在人工智能的世界里,一股力量彻底改变了我们思考和与机器互动的方式:变形金刚。不,不是那些变形为卡车或战斗机的变形玩具!变形金刚让人工智能模型能够追踪数据块之间的关系并得出含义——就像你解读这句话中的单词一样。这种方法为自然语言模型注入了新的活力,并彻底改变了人工智能格局。

在这篇文章中,我将解释 Transformer 架构、它如何为GPT和 BERT 等 AI 模型提供支持,以及它对生成式 AI 未来的影响。

生成式人工智能如何工作?

生成式人工智能 (GenAI) 分析大量数据,寻找模式和关系,然后利用这些见解创建模仿原始数据集的全新内容。它通过利用机器学习模型(尤其是无监督和半监督算法)来实现这一点。

那么,这项能力背后究竟在做什么?神经网络。这些网络受到人类大脑的启发,通过多层互连节点(神经元)获取大量数据,然后处理并解读其中的模式。这些见解随后可用于做出预测或决策。借助神经网络,我们可以创建各种内容,从图形和多媒体到文本甚至音乐。

这些神经网络会随着经验的积累而不断适应和改进,形成现代人工智能的支柱。回到变形金刚,它就像领导力矩阵,让擎天柱能够利用祖先的知识来指导自己的决策。

实现生成式人工智能有三种流行的技术:

生成对抗网络 (GAN)

变分自动编码器 (VAE)

变压器

研究前两个模型的工作原理有助于深入了解 transformer 的运行方式,因此让我们更深入地研究 GAN 和 VAE。

什么是生成对抗网络?(GAN)

生成对抗网络 (GAN) 是一种生成模型,它有两个主要组成部分:生成器和鉴别器。生成器尝试生成数据,而鉴别器则对其进行评估。

让我们用《变形金刚》系列中的汽车人和霸天虎来类比。汽车人是“生成器”,试图模仿和变身为地球上的任何车辆或动物。另一方面,霸天虎扮演“鉴别器”的角色,试图识别哪些车辆和动物是真正的汽车人。在他们交战时,汽车人会在霸天虎的敏锐眼光的激励下微调他们的输出。他们不断的斗争提高了生成器创建令人信服的数据的能力,以至于鉴别器无法分辨真假。

GAN 有很多局限性和挑战。例如,它们可能很难训练——因为存在诸如模型崩溃之类的问题,即无论输入是什么,生成器都会生成有限种类的样本,甚至是相同的样本。例如,它可能会重复生成相同类型的图像,而不是多样化的输出。

什么是变分自动编码器?(VAE)

变分自动编码器 (VAE) 是一种主要用于无监督机器学习的生成模型。它们可以生成类似于输入数据的新数据。VAE 的主要组成部分是编码器、解码器和损失函数。

在深度学习中,VAE 可视为 Cybertron 的高级变形室。首先,编码器就像一个详细的扫描仪,将变形金刚的本质捕捉到潜在变量中。然后,解码器旨在重建该形式,通常会产生微妙的变化。这种重建由损失函数控制,可确保结果反映原始结果,同时允许独特的差异。可以将其视为重建擎天柱的卡车形式,但偶尔会进行自定义修改。

VAE 有很多限制和挑战。例如,VAE 中的损失函数可能很复杂,在使生成的内容看起来真实(重建)和确保其结构正确(正则化)之间取得适当的平衡可能具有挑战性。

Transformer 与 GAN 和 VAE 有何不同

Transformer 架构引入了多项突破性创新,使其有别于 GAN 和 VAE 等生成式 AI 技术。Transformer 模型能够理解句子中单词的相互作用,从而捕捉上下文。与逐步处理序列的传统模型不同,Transformer 可以同时处理所有部分,因此效率高且对 GPU 友好。

想象一下你第一次看到擎天柱从一辆卡车变成一个强大的汽车人领袖的情景。这就是人工智能从传统模型过渡到 Transformer 架构时所取得的飞跃。谷歌的 BERT 和 OpenAI 的 GPT-3 和 GPT-4 等多个项目都是基于 Transformer 架构的,这两个项目是功能最强大的生成式人工智能模型。这些模型可用于生成类似人类的文本、帮助完成编码任务、从一种语言翻译成另一种语言,甚至回答几乎任何主题的问题。

此外,Transformer 架构的多功能性不仅限于文本,在视觉等领域也大有可为。Transformer 能够从大量数据源中学习,然后针对聊天等特定任务进行微调,这开启了 NLP 的新时代,其中包括 ChatGPT 等突破性工具。简而言之,Transformer 的潜力远不止眼前所见!

Transformer 架构如何工作?

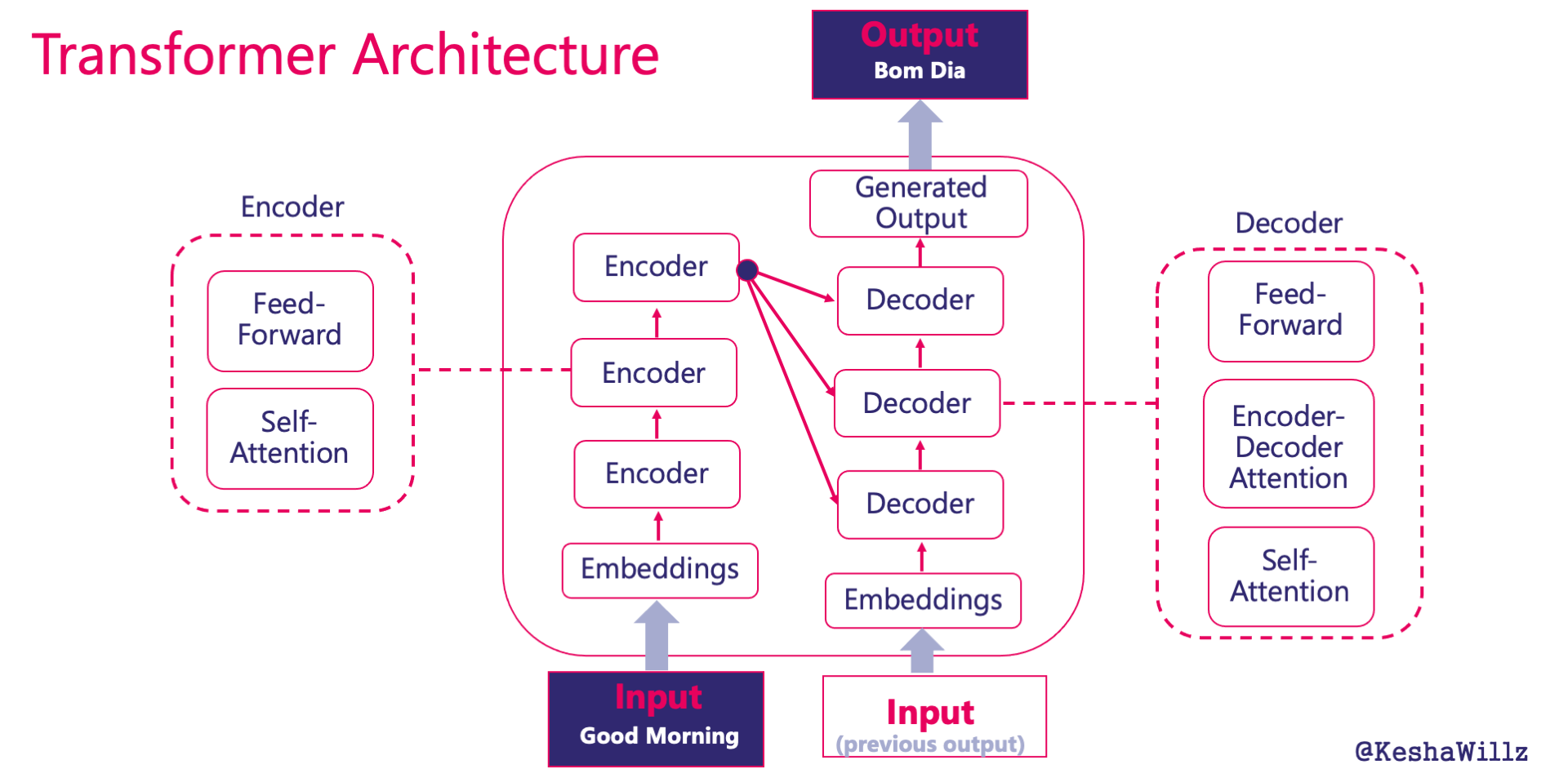

Transformer 是一种神经网络架构,它将一个文本序列作为输入,并生成另一个文本序列作为输出。例如,将英语(“Good Morning”)翻译成葡萄牙语(“Bom Dia”)。许多流行的语言模型都是使用这种架构方法进行训练的。

输入

输入是从提供的文本中提取的一系列标记,可以是单词或子单词。在我们的示例中,这是“早上好”。标记只是具有含义的文本块。在本例中,“早上好”和“早上好”都是标记,如果你添加“!”,那也是一个标记。

嵌入

收到输入后,序列将转换为数字向量,称为嵌入,用于捕获每个标记的上下文。这些嵌入允许模型以数学方式处理文本数据并理解语言的复杂细节和关系。相似的单词或标记将具有相似的嵌入。

例如,“好”这个词可以用一组数字来表示,这些数字可以捕捉其积极情绪和作为形容词的常见用法。这意味着它将与其他积极或类似含义的词语(如“好”或“令人愉快”)紧密相关,从而使模型能够理解这些词语之间的关系。

位置嵌入也包括在内,以帮助模型理解序列中标记的位置,确保在处理过程中理解和考虑标记的顺序和相对位置。毕竟,“热狗”的意思与“狗热”完全不同 - 位置很重要!

编码器

现在我们的 token 已经得到适当标记,它们将通过编码器。编码器通过理解输入数据(在我们的例子中是单词)的结构和细微差别来帮助处理和准备输入数据。编码器包含两种机制:自注意力机制和前馈机制。

自注意力机制将输入序列中的每个单词与其他每个单词联系起来,让该过程专注于最重要的单词。这就像给每个单词一个分数,代表它应该对句子中的每个其他单词给予多少关注。

前馈机制就像你的微调器。它从自注意力过程中获取分数,并进一步细化对每个单词的理解,确保准确捕捉细微差别。这有助于优化学习过程。

解码器

在每场史诗般的 Transformers 大战的高潮中,通常都会出现一次转变,即扭转局势的变化。Transformation 架构也不例外!编码器完成其部分后,解码器便登场。它使用自己的先前输出(解码器上一个时间步的输出嵌入)和来自编码器的处理后的输入。

这种双重输入策略确保解码器既考虑原始数据,又考虑迄今为止生成的内容。目标是创建一个连贯且符合上下文的最终输出序列。

输出

在这个阶段,我们得到了“Bom Dia”——代表翻译文本的新标记序列。这就像一场艰苦的战斗后擎天柱发出的最后胜利的吼声!希望你现在对 Transformer 架构的工作原理有了更多的了解。

Transformer 架构:ChatGPT 的 AllSpark

在《变形金刚》系列中,变形机器人是由一种名为 AllSpark 的古代神器驱动的。同样,Transformer 架构就是 ChatGPT 的 AllSpark——“赋予它生命”的核心技术(至少在允许它处理和连贯地生成语言的意义上)。

生成式预训练 Transformer (GPT) 是使用 Transformer 架构构建的模型,而 ChatGPT 是 GPT 的专门版本,针对对话互动进行了微调。因此,Transformer 架构之于 GPT 就像 AllSpark 之于 Transformers:是赋予它们能力的源头。

Transformers 和 ChatGPT 等工具的下一步计划是什么?

Transformer 架构已经为 AI 领域带来了重大变革,尤其是在 NLP 领域。借助 Transformer 架构,生成式 AI 领域可能会出现更多创新。

交互式内容创作:基于 Transformers 的生成式 AI 模型可用于实时内容创作设置,例如视频游戏,其中环境、叙述或角色是根据玩家动作动态生成的。

真实世界模拟:生成模型可用于模拟。这些模拟可以变得高度逼真,有助于科学研究、建筑甚至医疗培训。

个性化生成:鉴于 Transformer 的适应性,生成模型可能会根据个人品味、偏好或过去的经历生成个性化内容。想想根据个人心情或过去互动生成的音乐播放列表、故事或艺术品。

道德和社会影响:生成能力的提高带来了挑战。深度伪造、虚假信息和知识产权问题只是其中几个。生成式人工智能的发展将需要检测生成内容并确保合乎道德使用的机制。

结论:一种改变我们所知人工智能的架构

Transformers 架构有望显著提升生成式人工智能的功能和应用,突破机器创造能力的界限以及它们如何协助创造过程。现在,读完这篇文章后,你应该对它的工作原理有了更好的了解。

想要转变您的 GenAI 技能吗?

如果您刚刚开始接触生成式人工智能和 ChatGPT,那么学习即时工程是一个很好的起点。查看我的课程“即时工程以提高性能”,以掌握即时工程的高级技术!

免责声明:本内容来源于第三方作者授权、网友推荐或互联网整理,旨在为广大用户提供学习与参考之用。所有文本和图片版权归原创网站或作者本人所有,其观点并不代表本站立场。如有任何版权侵犯或转载不当之情况,请与我们取得联系,我们将尽快进行相关处理与修改。感谢您的理解与支持!

请先 登录后发表评论 ~