Red Sqirl-数据分析平台介绍

介绍

在过去的两年里,我一直在开发一个让新手也能进行大数据分析的程序。

Red Sqirl 是一款基于 Web 的大数据应用程序,可简化大型数据集的分析。借助 Red Sqirl,您可以快速访问 Hadoop 生态系统的强大功能,快速且经济高效地分析大量数据。它是一个用户可以扩展的开放平台,从而简化了 Hadoop 生态系统(Hadoop、Hive、Pig、HBase、Oozie 等),因为您不再需要掌握每一项底层技术。这使得 Red Sqirl 成为提高数据科学家生产力的最佳选择。

Red Sqirl 通过第三方处理和存储引擎访问您的数据,并将其组织成包。例如,Red Sqirl Pig 包可让您访问 Apache Pig。Red Sqirl 还将可重复使用的分析部分归类为模型。

此外,Red Sqirl 是开源且免费的。

您可以在 www.redsqirl.com 了解更多信息

此外,本教程的视频版本可供下载:https://youtu.be/LL6adYq4YL4

这里的想法是让人们一睹 Red Sqirl 的能力。

概括

- 步骤 1:了解 Red Sqirl 界面

- 第 2 步:了解如何将数据复制到 HDFS

- 步骤 3:了解如何构建工作流程

- 步骤 4:了解如何运行该工作流程

- 步骤 5:了解如何从该工作流程中提取结果

Red Sqirl 是一个可以直接安装在 Hadoop 集群上的平台。本教程需要Red Sqirl Docker 映像。

此时,我们假设您已经知道 Red Sqirl 是什么,并且已经成功安装它。

如果您想在本地环境中逐步遵循本教程,您需要知道 Red Sqirl 安装文件夹的位置(/opt/redsqirl-2.6.0-0.12/)并且已安装 Red Sqirl Pig 包。

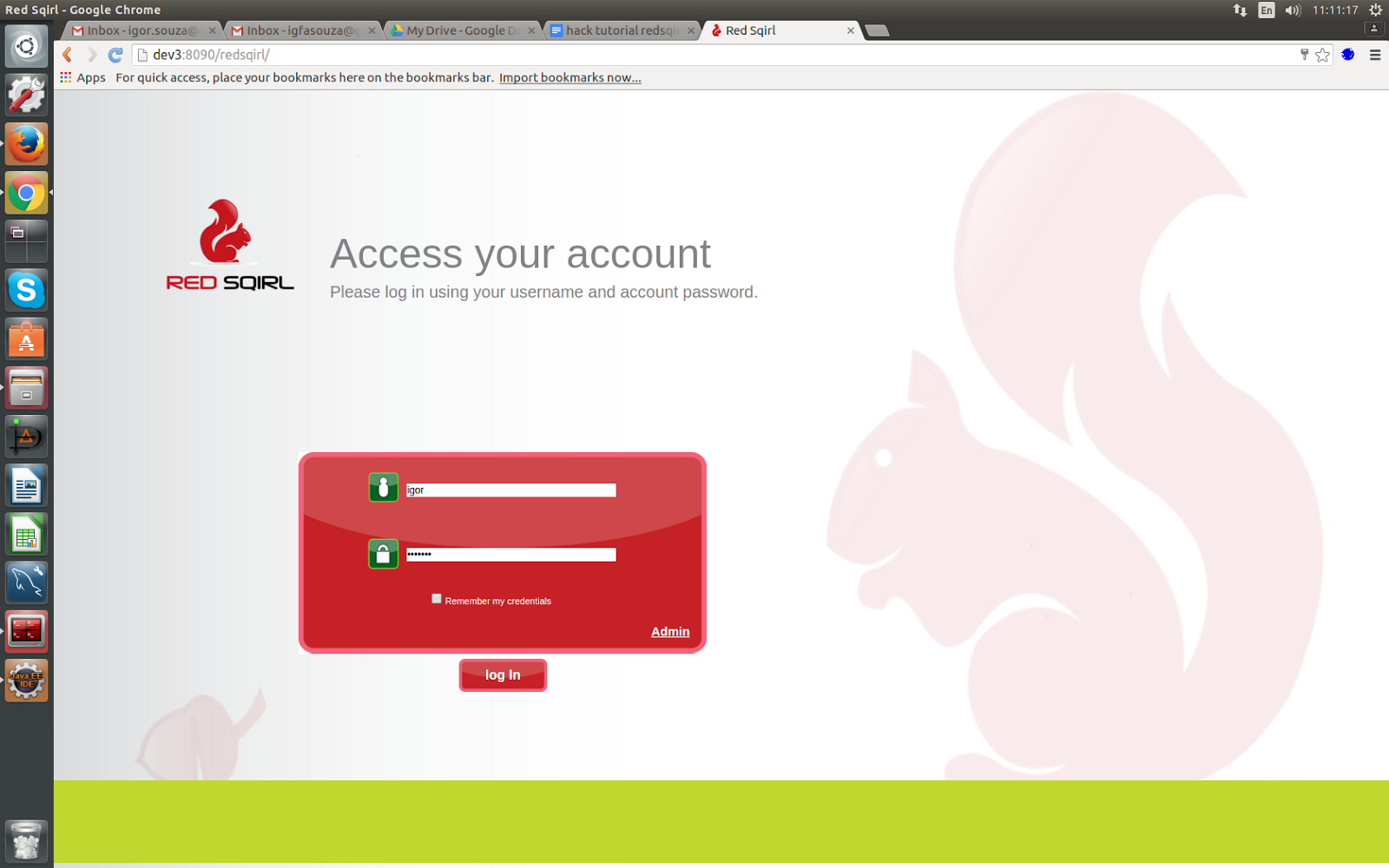

要登录,我们只需使用您用于安装 Red Sqirl 的操作系统用户名和密码。

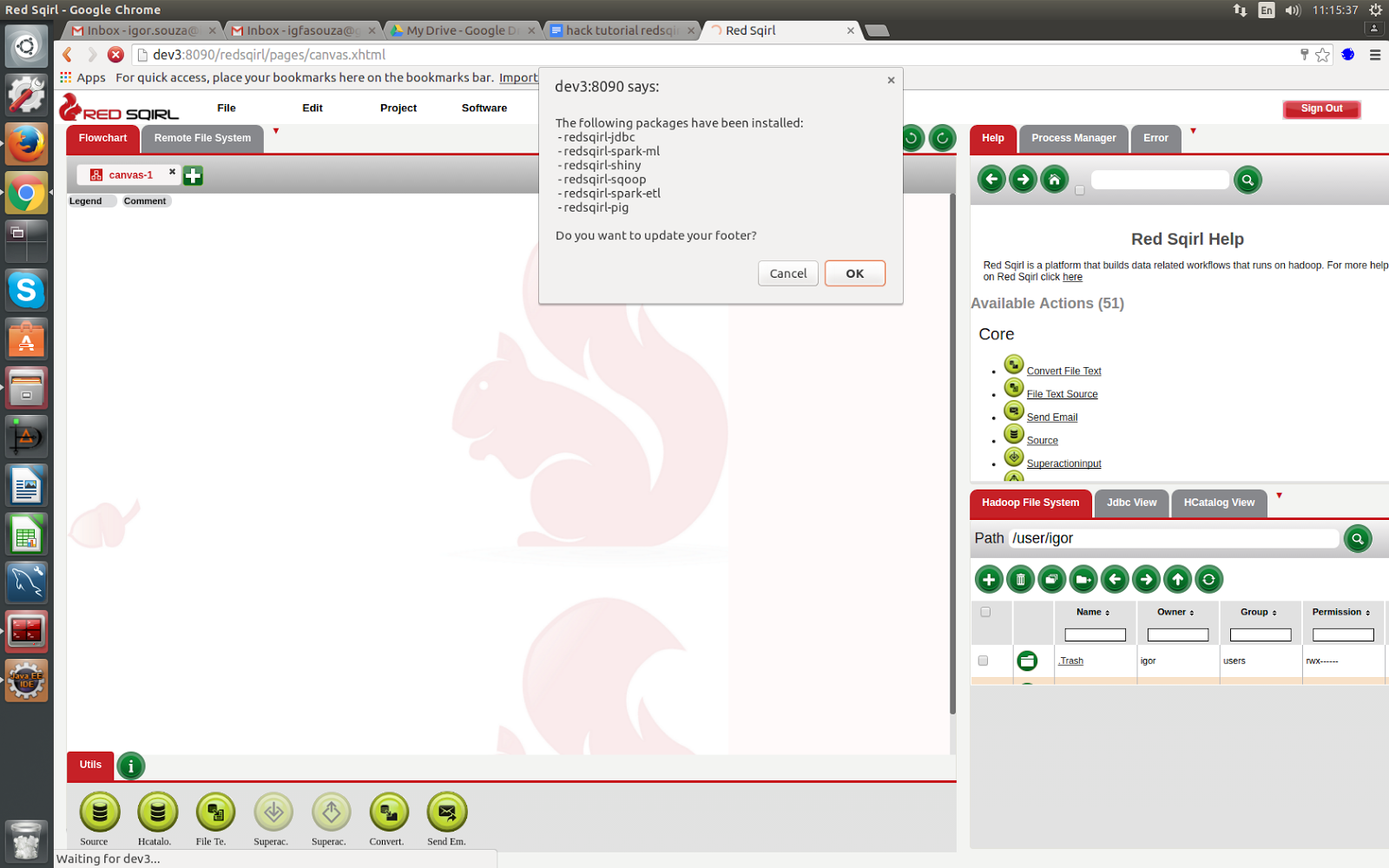

如果您是首次登录,系统会提示您更新页脚菜单。点击“确定”。

步骤 1:了解 Red Sqirl 界面

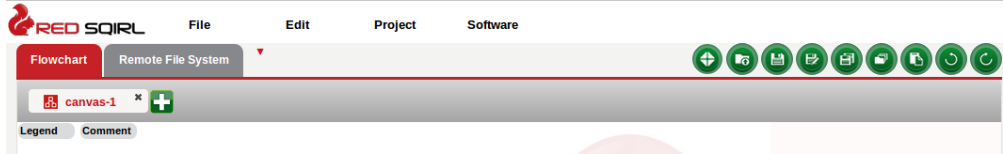

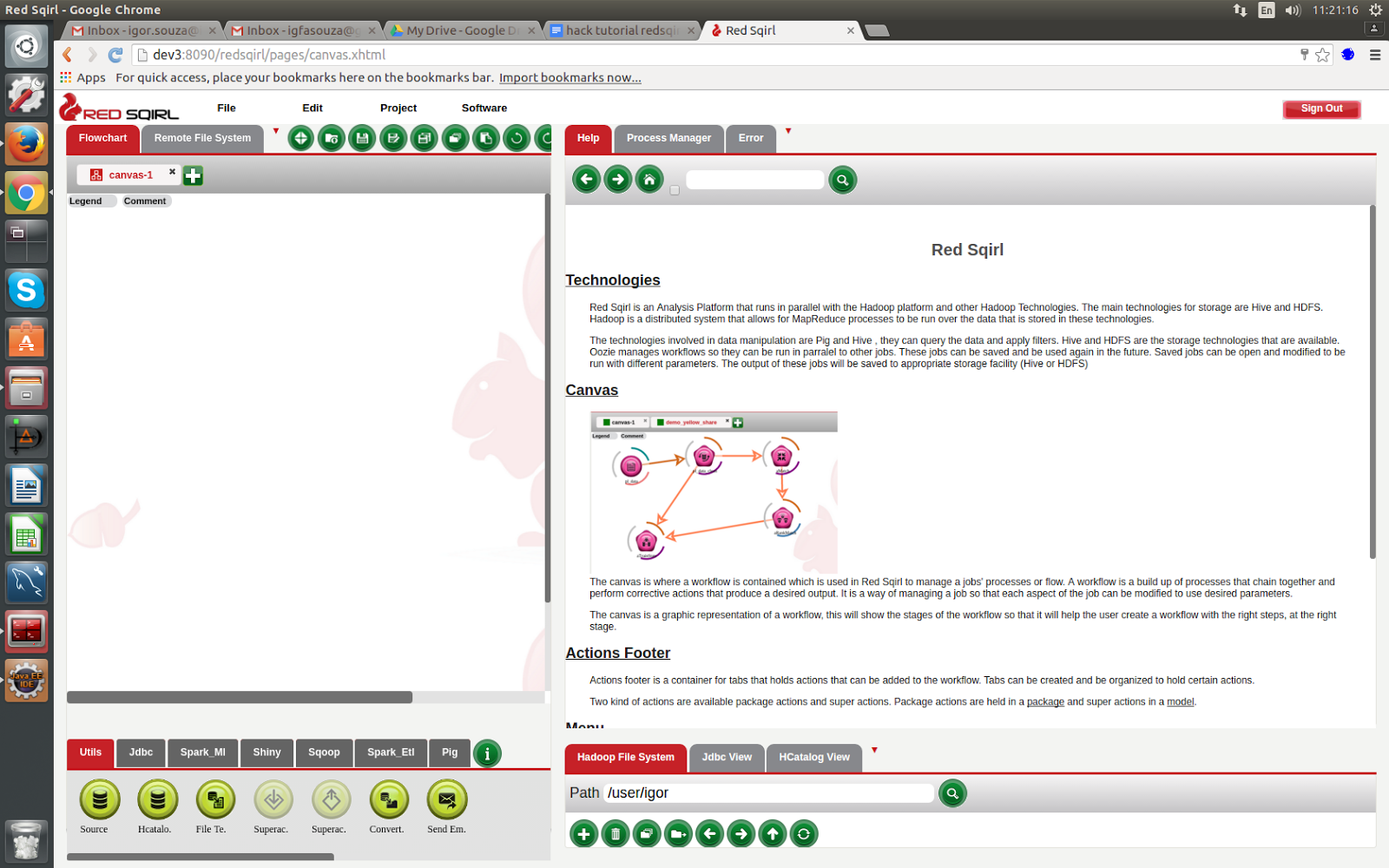

这是我们的 Red Sqirl 界面。如您所见,它由三个主要部分组成。

第 1 部分:左侧有两个标签

- 流程图画布:这是执行工作流程的地方。

- 远程文件系统:我们可以通过该系统连接到任何 ssh(安全外壳)服务器。

**流程图画布:**

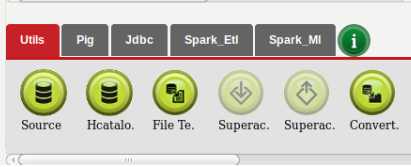

流程图画布是我们创建数据分析工作流的地方。它还包含我们可用于分析的操作。我们可以在画布底部的页脚中找到它。

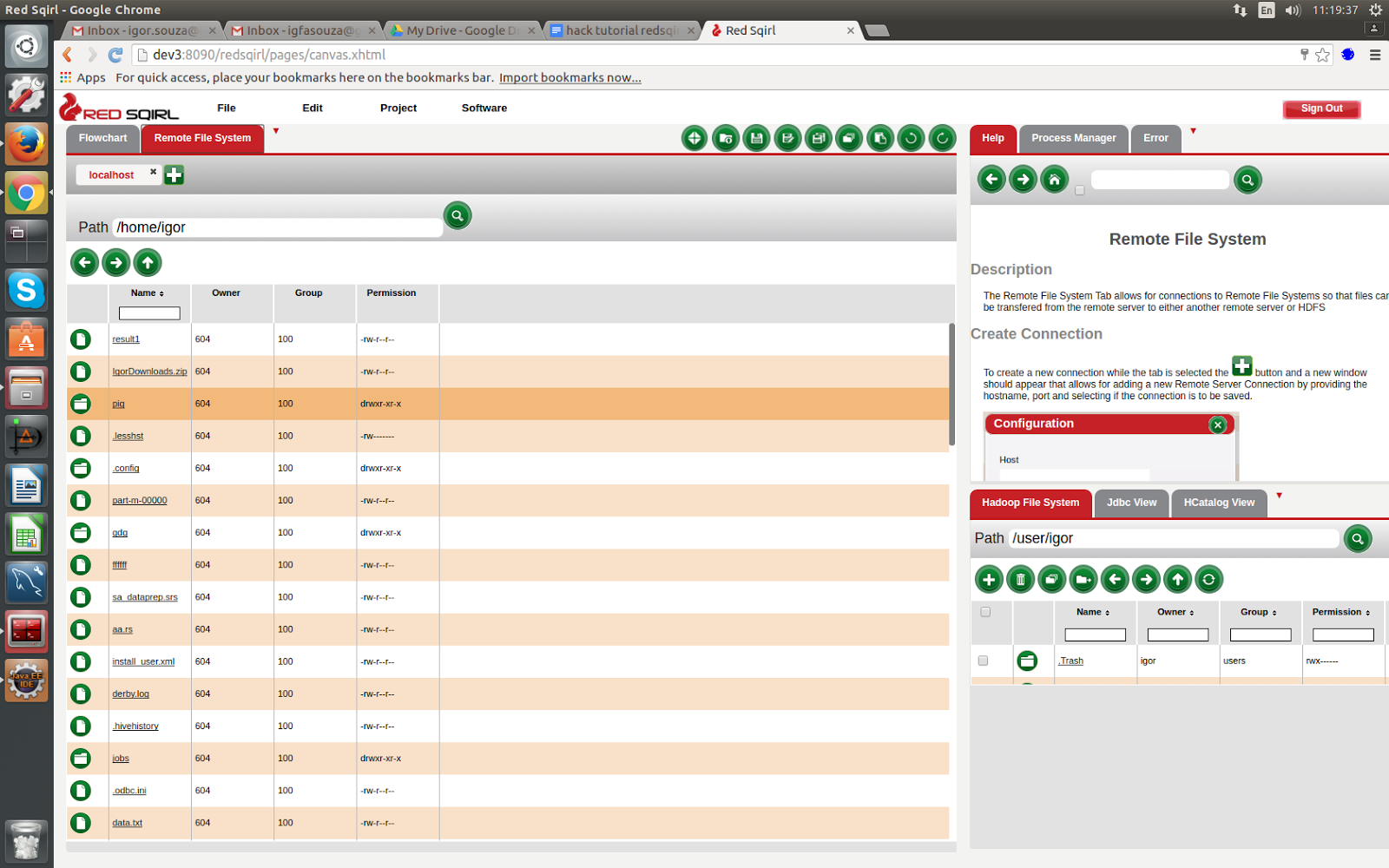

** 远程文件系统:**

在这里我们可以连接到任何 ssh 服务器。例如,你可以使用 ssh localhost,它将对应于安装 Red Sqirl 的服务器。

单击远程文件系统选项卡,然后单击加号按钮。然后根据需要填写表格。现在我们可以看到我们的远程文件系统。

第 2 部分:右上角是帮助选项卡

帮助选项卡由以下部分组成:

- 我们可以找到通用选项的主要部分

- 行动部分

- 我们可以通过点击“主页”按钮找到操作部分,

- 本节介绍我们可以使用的每个拖放操作。

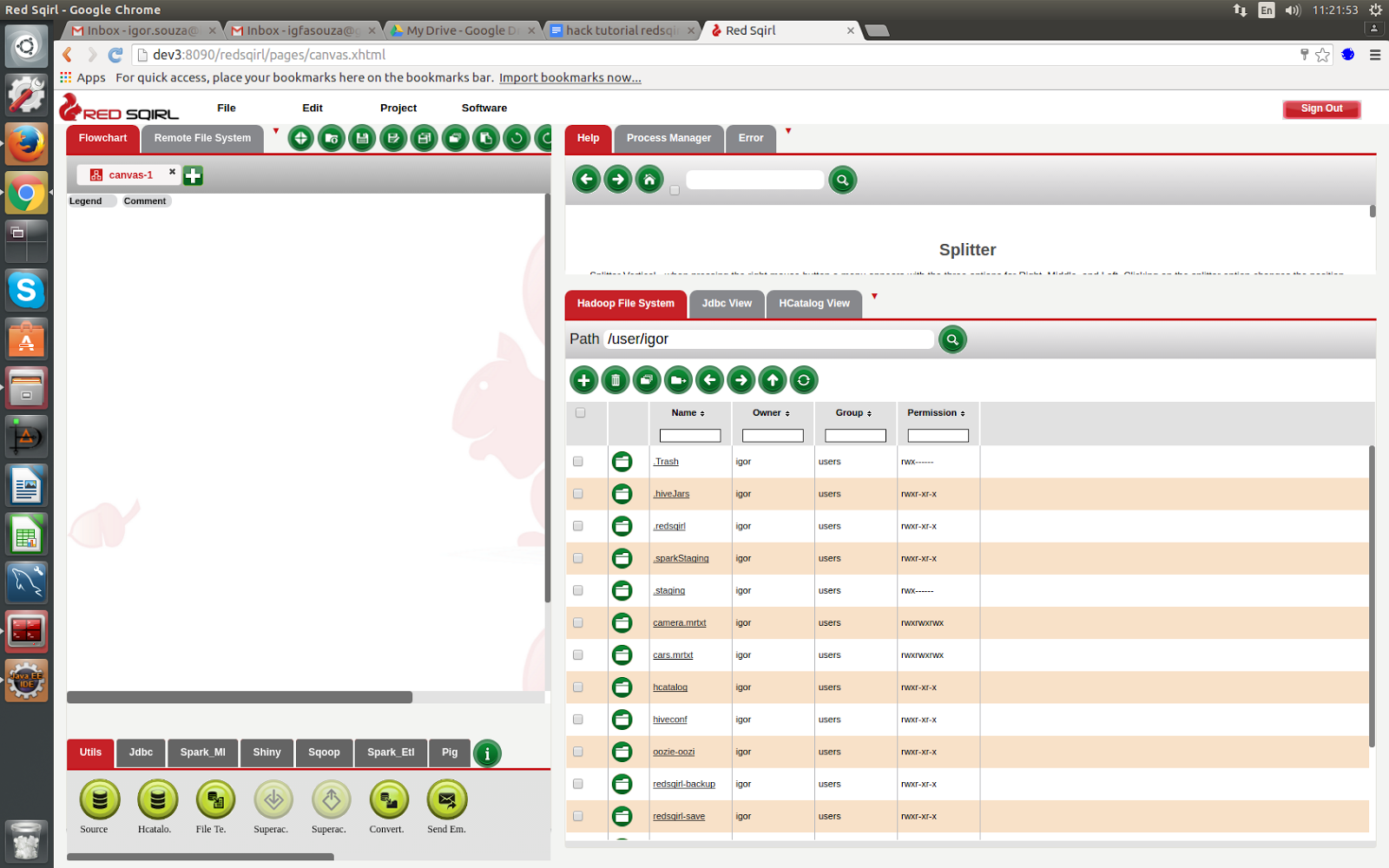

第 3 部分:右下角是 Hadoop 分布式文件系统

以上就是Red Sqirl界面的三个主要部分。

第 2 步:了解如何将数据复制到 HDFS

在 Red Sqirl 安装文件夹中,我们已经为您提供了本教程的一些数据。因此,我们现在需要做的是将这些数据复制到我们的 HDFS(Hadoop 分布式文件系统)中。

为此,我们首先返回远程文件系统。

- 进入 Red Sqirl 安装文件夹,在我的情况下是 /opt/redsqirl-2.4.0-0.12

- 找到名为“tutorial_data”的文件夹并将其拖放到我们的 HDFS 窗口的任何位置。

此文件夹中有几个不同的文件。在本教程中,我们将使用名为getting_started.txt的文件。现在我们可以单击tutorial_data并单击getting_started.txt 文件。

步骤 3:开始分析

返回流程图画布部分。

- 配置 HDFS 文件源

- 选择两列的总和

- 获取某列的平均值

- 按另一列分组时获取某列的总和

- 连接两个表

- 使用条件过滤表

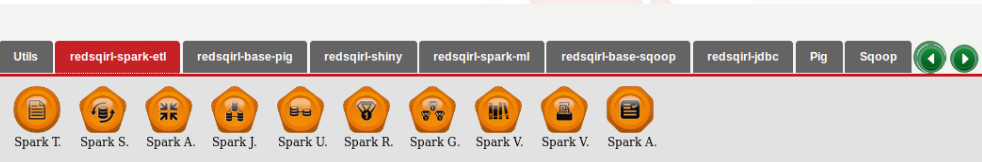

为了完成这些任务,我们首先需要更改页脚。操作页脚是流程图选项卡左下方的小框架。

- 单击绿色信息符号。

- 一旦左栏出现配置弹出窗口,请单击“+”。

- 在新的空行中输入“extraPig”。

- 单击“...”符号。

- 在新窗口中,从下拉菜单中选择 redsqirl_pig

- 单击 pig_audit 旁边的复选框,然后单击“选择”按钮。

- 单击“确定”。

- 单击“确定”。

您应该会看到一个名为“extraPig”的新页脚选项卡,其中包含“Pig Audit”。要删除此新菜单,您需要执行以下操作。

- 单击绿色信息符号。

- 点击“extraPig”旁边的复选框。

- 单击表头中的删除按钮(垃圾桶图标)。

- 单击“确定”。

**让我们分析一下数据。**

- 分析总是从源动作开始,因此我们首先设置此动作。

- 在操作页脚中,将新的源图标拖到画布上。

- 现在我们只需双击它就可以进行配置。

- 将动作命名为“沟通”

- 评论操作“配置教程数据”。

- 单击“确定”。

- 现在我们将看到一个分步窗口。

- 选择“Hadoop 分布式文件系统”作为数据类型,然后单击下一步。

- 选择“TEXT MAP-REDUCE DIRECTORY”作为数据子类型,然后单击下一步。

- 接下来我们必须选择保存文件的路径。

- 单击搜索按钮,然后单击刷新按钮,找到教程数据文件,然后找到入门文件pig_tutorial_data.mrtxt

- 单击pig_tutorial_data.mrtxt旁边的单选按钮。如果找不到,请单击搜索按钮刷新视图。单击确定。

- 我们的数据现在处于源操作中。在此阶段,您将看到数据正确显示在屏幕上,字段的名称为“Field1 Long,Field2 Long...”

- 在下一步中,我们可以通过点击表格左上角的编辑按钮来更改字段名称及其类型

让我们重命名字段:

- 将“subscriber_number STRING、Friend STRING、offpeak_voice INT、offpeak_sms INT、offpeak_mms INT、peak_voice INT、peak_sms INT、peak_mms INT、sna_weight INT、subscriber_onnet INT、friend_onnet INT”复制并粘贴到值字段中

- 单击“确定”。您将确认标题是正确的。

- 单击“确定”退出配置窗口。

- 如果将鼠标光标放在源操作上,您将能够看到一些配置详细信息

- 通过进入文件 > 保存来保存工作流,并将其命名为pig_tutorial。默认情况下,它保存在 redsqirl-save HDFS 目录中,文件扩展名为“.rs”。单击确定保存。

我们如何查看修改后的数据呢?

我们现在可以看到源操作图标周围的弧线已经发生了变化。

图标周围的弧线提供有关该操作状态的信息。

要查看弧线的含义,只需单击画布左上角的图例。要隐藏图例,只需再次单击它。

让我们回顾一下:

- 我们已经完成了界面

- 我们已将数据复制到 HDFS

- 我们已经设置了源文件并对其进行了配置

现在我们准备开始处理数据了。

设置 Pig 聚合器操作 (PAA)

Pig 聚合器是一种操作,允许在选择列时使用聚合方法,就像在 SQL 语句中一样。这些聚合方法包括 AVG、MAX、SUM 等。此操作将按所选属性或全部进行分组(如果未选择任何属性,则默认为全部)。

在 Pig 页脚菜单中,我们可以选择聚合器操作。

将 PAA 拖到画布上。

通过单击图像和源操作的弧线之间,然后单击猪聚合器图像,在刚刚配置的源和新的 PAA 之间创建链接。(您将看到连接两个图标的箭头)

打开新的猪聚合器图标,将元素命名为“nl_sum”,然后单击“确定”。

第一页让我们选择要聚合的字段。在本例中,我们想按“subscriber_number”进行聚合。选择“subscriber_number”,然后在 Group by 交互中单击“Select”。

单击“下一步”。

在第二页上,我们可以逐个字段进行操作。

从生成器交互的下拉菜单中选择“复制”,然后单击“确定”。(我们还可以通过单击“配置”按钮来更详细地选择生成。每个选项卡都是不同的配置选项。)

我们还可以对行进行排序——在表格顶部单击“+”符号以向表格添加新行。需要注意的是:每行上的复选框仅用于排序和删除,我们不需要勾选每行才能继续。

单击新行操作字段中的笔,然后单击“SUM()”函数并添加参数“communication.offpeak_voice”和“communication.peak_voice”。在参数之间添加一个“+”符号,以便操作将显示为“SUM(communication.offpeak_voice + communication.peak_voice)”

单击“确定”。

在字段名称中,为新列输入“total_voice”,并将类型更改为DOUBLE。

单击“下一步”。

下一页显示我们可以对数据进行排序。我们现在不进行排序,因此单击下一步。

接下来的页面是关于过滤和格式,单击“确定”保留默认参数。(过滤选项是另一个文本编辑器,我们可以在其中创建过滤条件。)

我们可以选择输出的分隔符,我们在分隔符框中使用逗号。默认情况下,输出类型是压缩的。在 Red Sqirl 中,输出格式对于将一个操作链接到下一个操作非常重要,两种类型需要兼容。

如果我们愿意,我们还可以选择对输出进行审计。

单击“确定”。

免责声明:本内容来源于第三方作者授权、网友推荐或互联网整理,旨在为广大用户提供学习与参考之用。所有文本和图片版权归原创网站或作者本人所有,其观点并不代表本站立场。如有任何版权侵犯或转载不当之情况,请与我们取得联系,我们将尽快进行相关处理与修改。感谢您的理解与支持!

请先 登录后发表评论 ~